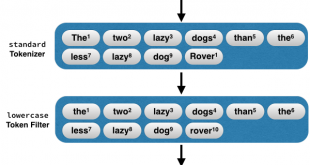

قطعه بندی متن (Tokenizer) در بخش های قبلی به روش های تشخیص زبان در متون اشاره کردیم و همچنین به نقش واحد ساز (Tokenizer) در پردازش متن پرداختیم. در این مبحث با استفاده از جی هضم (Jhazm) به قطعه بندی متون میپردازیم. Tokenizer ابزاری …

ادامه مطلببایگانی برچسب: Tokenizer

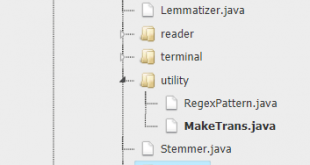

پردازش متن با Jhazm نسخه جاوا کتابخانه هضم برای پردازش زبان فارسی

jHazm نسخه جاوایی هضم از کتابخانه پایتون برای پردازش زبان فارسی است. کتابخانه HAZM برای انجام پردازش های لازم بر روی زبان فارسی توسط دانشجویان دانشگاه علم و صنعت در سال 1392 به صورت متن باز و با استفاده از کتابخانه NLTK منتشر شد. لایسنس …

ادامه مطلبنقش واحدساز (Tokenizer) در پردازش متن و متن کاوی

واحدساز (Tokenizer) در بخش های قبلی به روش های تشخیص زبان در متون اشاره کردیم در این مبحث به نقش واحد ساز (Tokenizer) در پردازش متن میپردازیم. واحدساز (Tokenizer) مرز کلمات را در متون تشخیص داده و متن را به دنبالهای از کلمات تبدیل …

ادامه مطلب خانه بیگ دیتا تحلیل شبکه های اجتماعی، متن کاوی، داده کاوی، اوسینت و داده های حجیم

خانه بیگ دیتا تحلیل شبکه های اجتماعی، متن کاوی، داده کاوی، اوسینت و داده های حجیم