اوضاع و آمار بیگ دیتا در سال 2023 و 2024

اوضاع و آمار بیگ دیتا در سال 2023 در یک دقیقه

در پست های قبل خواص بیگ دیتا را بررسی نمودیم. در این پست به آمار بیگ دیتا تولید شده در دنیا میپردزیم. حجم اطلاعاتی که تا سال ۲۰۰۳ توسط انسان ایجاد شد تنها ۵ اگزابایت است. امروزه این حجم از اطلاعات تنها در عرض دو روز ایجاد میشود. در تحقیقی نشان داد که هرروز ۲.۵ اگزابایت داده تولید میشود. حدود ۹۰ درصد دادههای موجود تنها در دو سال اخیر تولیدشده است. هر رایانه شخصی حدود ۵۰۰ گیگابایت اطلاعات در خود نگهداری میکند. آمارها نشان میدهد در دنیا حدود ۲۰ میلیون رایانه شخصی وجود دارد.

درگذشته فرآیند توصیف ژن انسان حدود ده سال طول میکشید درحالیکه امروز در کمتر از یک هفته انجام میشود.در حوزه وب، حجم زیاد اطلاعات با رشد نمایی ۱۱ میلیارد صفحه در ۲۰۰۵ (ایران ده میلیون) و ۱۵۰ میلیارد صفحه در ۲۰۱۴ (ایران ششصد میلیون) تولید میشود و در محیط پویا صفحات جدید هم با نرخ ۸ درصد در هفته تولید میشوند، البته ۲۰ درصد صفحات موجود بعد از یک سال قابلدسترس نیستند.

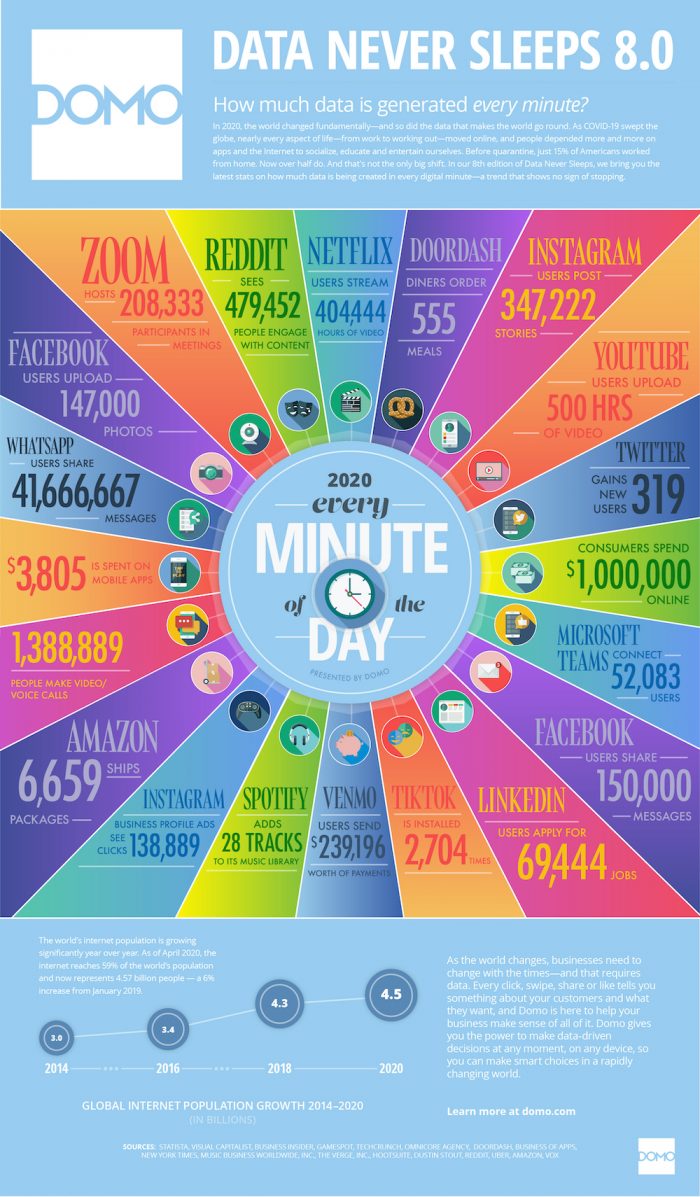

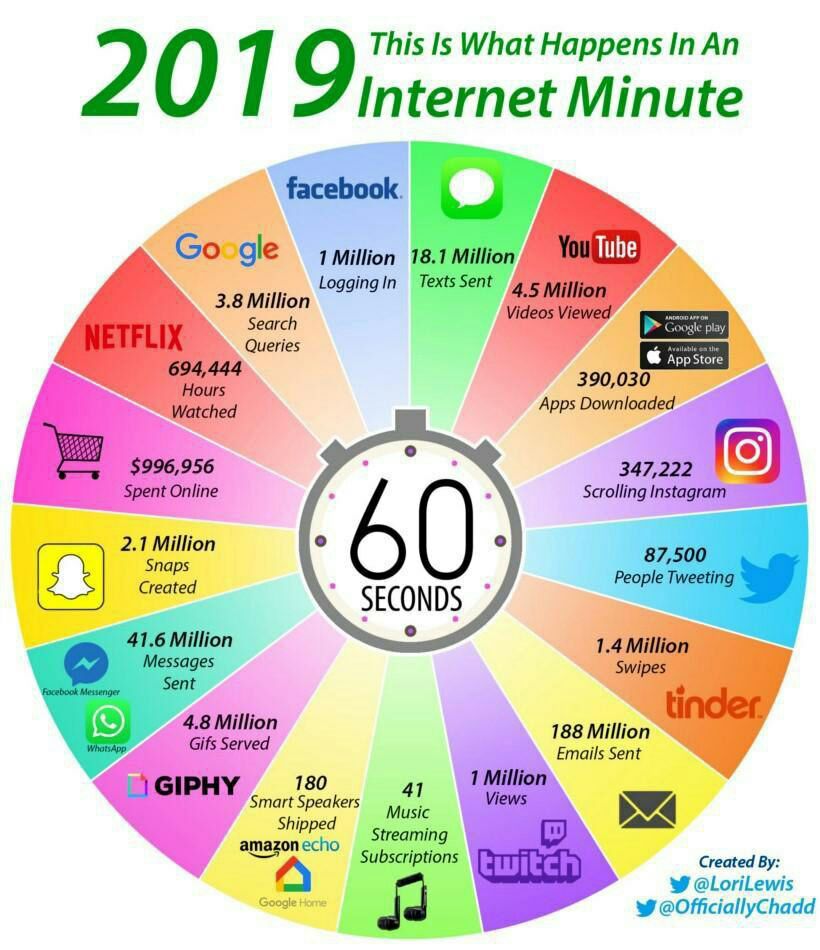

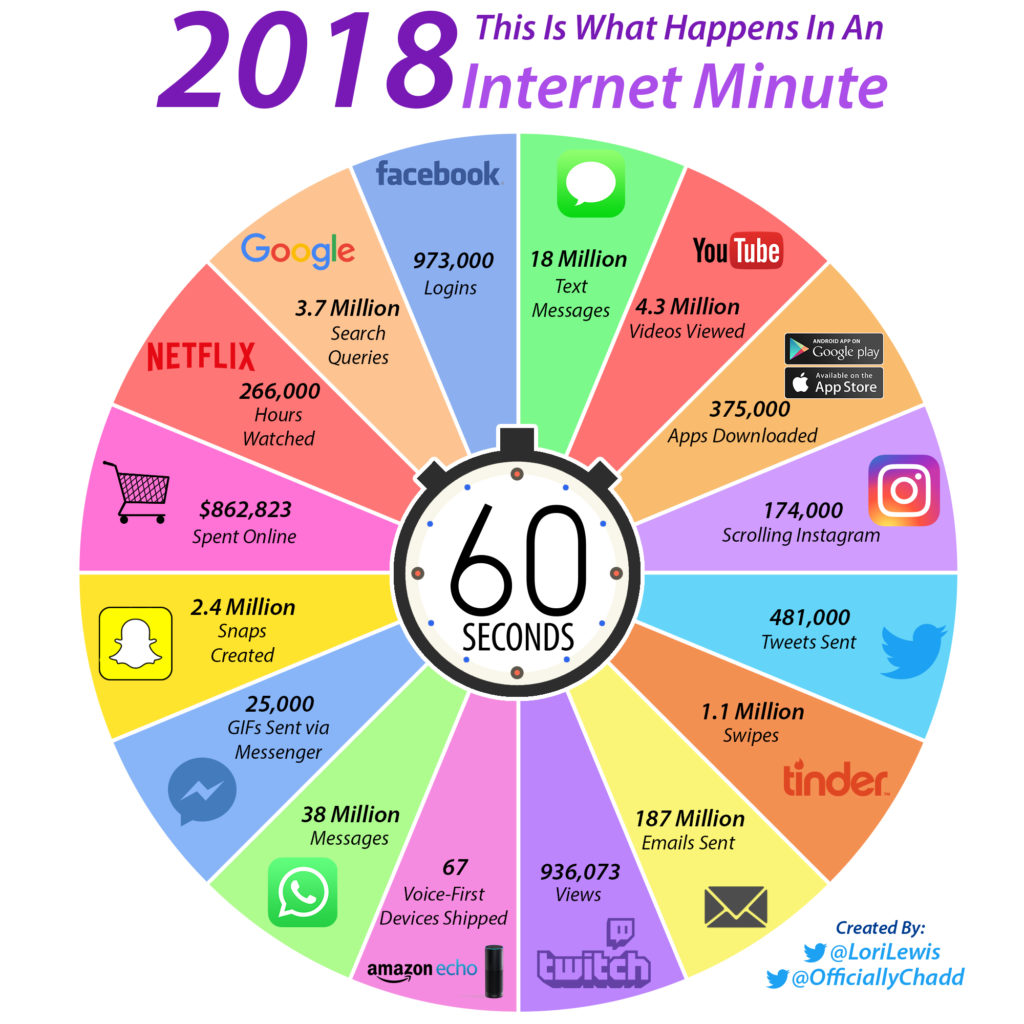

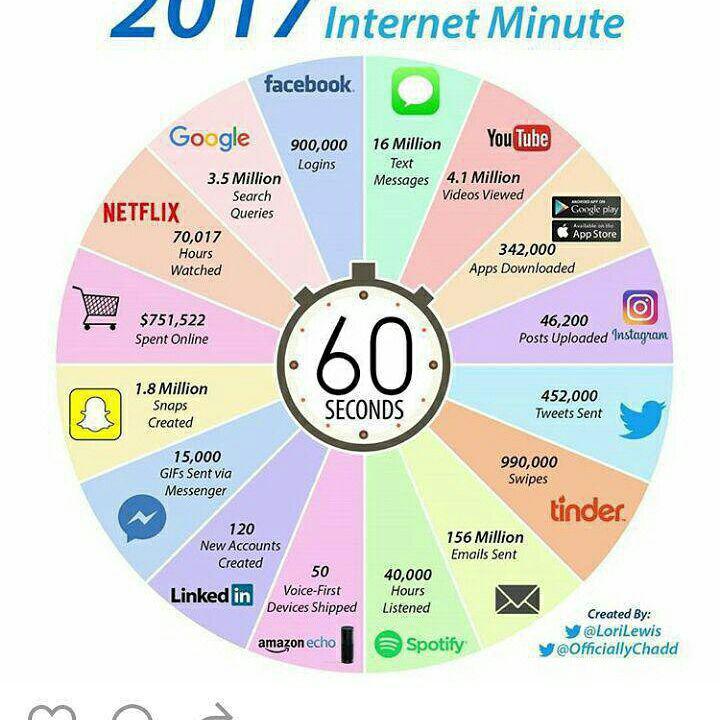

- عکس زیر تولید محتوا، تراکنش کاربران و بازدیدها را در وب دنیا فقط در یک دقیقه نشان میدهد.

:low_brightness:سرعت تولید بیگ دیتا در یک دقیقه در سال ۲۰۲۰

:pushpin:یک دقیقه در اینترنت (سال 2020)

:small_red_triangle:مطابق با داده های گردآوری شده توسط Visual Capitalist، در طول یک دقیقه:

:small_red_triangle: 347.222 استوری در اینستاگرام گذاشته شده

:small_red_triangle: 2.704 اپلیکیشن TiKTok نصب می شود

:small_red_triangle: 6659 خرید در سایت آمازون صورت می گیرد.

:small_red_triangle: 208.333 نفر با zoom در جلسات آنلاین شرکت می کنند

:small_red_triangle: 319 کاربر جدید به توئیتر اضافه شده

:small_red_triangle: 41.7 میلیون پیام در واتس اپ به اشتراک گذاشته می شود.

- Big Data

Big Data واژه ای است برای مجموع های از ست داده های بسیار بزرگ و پیچیده، که استفاده از ابزارهای مدیریت پایگاه داده در دست و یا برنامه های کاربردی سنتی پردازش داده، برای پردازش آنها دشوار خواهد بود. چالش ها شامل استخراج، Curation، ذخیره سازی، جستجو، اشتراک، انتقال، آنالیز و بصری سازی است. در سال 2012، محدودیت اندازه ست داده ها، با زمان پردازش معقول، بر اگزابایت، میلیون ترابایت، قرار داشت.

کار با Big Data با استفاده از سیستم های مدیریت دیتابیس های رابطه ای و بسته های بصری سازی و تحلیل های دسکتاپ، دشوار است. مواجهه با Big Data نیازمند نرم افزار موازی در حال کار بر روی ده ها، صدها و یا حتی هزاران سرور هستند. آنچه که Big Data شناخته می شود، بنا بر قابلیت های سازمان مدیریت کننده آن، و قابلیت های برنامه های کاربردی که به طور سنتی در آن زمینه داده پردازش و تحلیل می کنند، متفاوت است. برای برخی سازمان ها، رویارویی با صدها گیگابایت داده برای اولین بار ممکن است نیاز به بازبینی آپشن های مدیریت داده را ایجاد کند. برای برخی دیگر، ممکن است تا ده ها و صدها ترابایت طول بکشد که سایز داده به موضوعی قابل توجه تبدیل شود.

- افزایش تقریبی نه برابری حجم دادهها به ازا هر پنج سال (آمار بیگ دیتا)

از سال ۲۰۱۲ به بعد در هرروز ۱۰۰۰ پتابایت داده تولید میشود که به دنبال خود مستلزم ذخیرهسازی، تحلیل، جستجوها، تمیزکاری دادهها، اشتراکها و غیره در دادههاست که باید در حوزه مختلف انجام شود. این موضوع باعث شده است که پژوهشگران و دانشمندان به دنبال ایجاد ساختارها، متدولوژیها، روشها و رویکردهای جدیدی برای مدیریت، کنترل و پردازش این حجم از دادهها باشند که این تلاشها در ذیل سایه دادههای عظیم مطرحشده است. دادههای عظیم یک اصطلاح برای مجموعههای داده خیلی بزرگ است که ازنظر ساختار، پیچیدگی و منابع تولید بسیار متنوع هستند و ذخیره و آنالیز آنها کار پیچیدهای است.

در سال ۲۰۱۳، دادههای عظیم بهعنوان یک پروژه مهم و جهانی مطرح شد. پروژهای که به جمعآوری، بصری سازی و آنالیز مقدار زیادی داده میپردازد. در راستای این پروژه اطلاعات آماری زیادی ارائه گردید. فیسبوک ماهانه حدود ۹۵۵ میلیون کاربر فعال به ۷۰ زبان زنده دنیا دارد و حدود ۱۴۰ بیلیون عکس در آن بارگذاری میشود و ۱۲۵ میلیون ارتباط دوستی برقرار میگردد. هرروزه ۳۰ بیلیون نوشته و ۲.۷ بیلیون لایک و توضیحات ارسال میگردد. در یوتیوب هر دقیقه ۴۸ ساعت ویدیو بارگذاری و هرروزه ۴ بیلیون فیلم اجرا میگردد.

گوگل نیز از خدمات زیادی پشتیبانی میکند ازجمله ۷.۲ بیلیون صفحه در هرروز و ۲۰ پتابایت (۱۰۱۵ بایت) فرآیند روزانه و ترجمه به ۶۶ زبان؛ یک بیلیون توییت در هر ۷۲ ساعت، بیشتر از ۱۴۰ میلیون فعالیت کاربران توییتر است. تعداد ۵۷۱ وبگاه جدید در هر دقیقه از روز ایجاد میشود. پیشبینی میشود در طی دهه آینده حجم اطلاعات ۵۰ بار افزایش یابد، البته همزمان تعداد فنّاوریهای خاص اطلاعاتی که برای نگهداری این دادهها ایجاد میشود نیز ۱.۵ برابر میگردد.

منابع:

آدرس کانال تلگرام سایت بیگ دیتا:

آدرس کانال سروش ما:

https://sapp.ir/bigdata_channel

جهت دیدن سرفصل های دوره های آموزشی بر روی اینجا کلیک کنید.

جهت ثبت نام در دوره های آموزشی بر روی اینجا کلیک کنید.

بازدیدها: 6630

برچسبBig Data BigData 2017 BigData2017 آمار بیگ دیتا اوضاع بیگ دیتا در سال اوضاع و آمار بیگ دیتا اوضاع و آمار بیگ دیتا در سال بیگ دیتا بیگ دیتا در ایران داده های حجیم کلان داده

همچنین ببینید

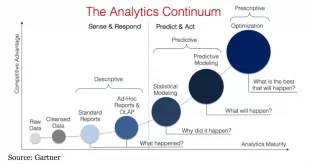

سطح بلوغ بیگ دیتا یا کلان داده حرکتی به سمت شرکت های داده محور

توسعه و اجرای استراتژی کلان داده برای سازمان ها کار آسانی نیست، به خصوص اگر …

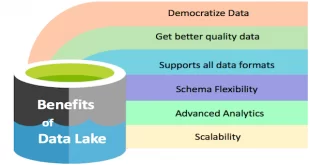

دریاچه داده (Data Lake) چيست و چه تفاوتی با باتلاق داده (Data Swamp) دارد

دریاچه داده (Data Lake) و مفهوم بیگ دیتا دو واژه ناگسستنی هستند به عبارتی Data …

2 دیدگاه

دیدگاهتان را بنویسید

برای نوشتن دیدگاه باید وارد بشوید.

خانه بیگ دیتا تحلیل شبکه های اجتماعی، متن کاوی، داده کاوی، اوسینت و داده های حجیم

خانه بیگ دیتا تحلیل شبکه های اجتماعی، متن کاوی، داده کاوی، اوسینت و داده های حجیم

منم با نظر دوستمون حمید رضا موافقم الان این مباحث در ایران متاسفانه بازار کاری ندارن.

ولی میشه گفت آینده بازار کار ما بیگ دیتا خواهد بود.

سلام

دوستان عزیز

من در زمینه داده کاوی و کارهای پژوهشی و دانشگاهی کردم

اما برای کار واقعی و کسب درآمد به خصوص در شهرستان ها کار واقعی به نظر من نیست

دیدگاهی که پیدا کردم اینه اکثر مباحث هوش در ایران جنبه آکادمیک داره

ممنون میشم مشاوره و راهنمایی کنید